책 소개

요약

머신러닝의 원론과도 같은 책이다. 저자 케빈 머피는 브리티시컬럼비아대학교(University of British Columbia)에서 교수로 재직한 후 구글 딥마인드에서 팀을 이끌고 있는 저명한 학자로, 그의 머신러닝 관련 저서는 많은 독자에게 널리 사랑받아 왔다. 이 책은 딥러닝 뿐만 아니라 머신러닝 학습을 위한 기초적인 수학적 토대 및 다양한 방법론을 폭넓게 다루고 있으며, 머신러닝 학습에 깊이를 더하고자 하는 독자들에게 최고의 선택이 될 것이다.

추천의 글

“딥러닝 혁명은 지난 수십 년간 머신러닝 분야를 변화시켰다. 이는 뇌가 학습하는 방법을 모방하려는 시도에서 비롯됐지만, 통계학, 정보이론, 결정이론, 최적화의 기본적인 원칙을 기반으로 한다. 이 책은 이러한 원칙을 탁월하게 설명하며, 이를 활용하는 수많은 ‘전통적인’ 머신러닝 방법론을 설명한다. 또한 같은 원칙이 어떻게 수많은 특성 층을 갖는 딥러닝 시스템에도 적용되는지 보여준다. 이는 서로 다른, 오래되거나 새로운 ML 접근법 사이의 관계 및 반대급부를 이해할 수 있게 해주는 일관적인 프레임워크를 제공한다.”

─ 제프리 힌튼(Geoffrey Hinton),

토론토 대학교 컴퓨터 과학 명예교수(Emeritus Professor of Computer Science, University of Toronto),

구글 엔지니어링 펠로우(Engineering Fellow, Google)

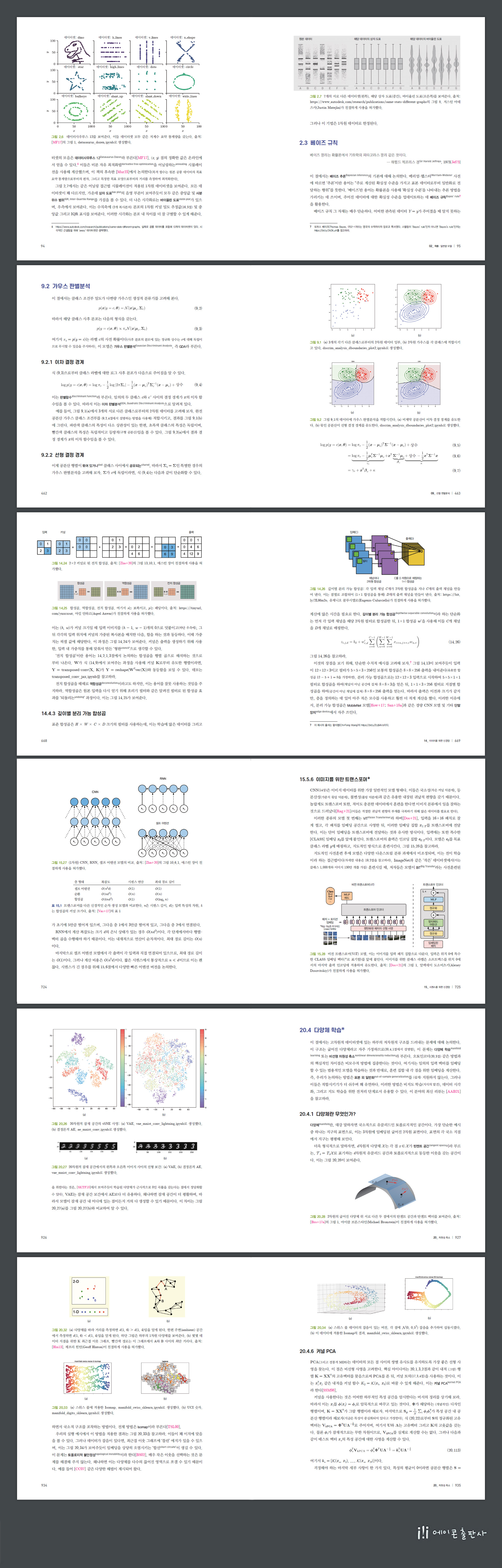

상세이미지

목차

목차

- 01장. 서론

- 1.1 머신러닝이란 무엇인가?

- 1.2 지도 학습

- 1.2.1 분류

- 1.2.2 회귀

- 1.2.3 과적합과 일반화

- 1.2.4 ‘공짜 점심은 없다’ 정리

- 1.3 비지도 학습

- 1.3.1 군집화

- 1.3.2 잠재된 ‘변형 인자’ 발견하기

- 1.3.3 자기 지도 학습

- 1.3.4 비지도 학습 평가

- 1.4 강화 학습

- 1.5 데이터

- 1.5.1 몇 가지 공통적인 이미지 데이터셋

- 1.5.2 공통적인 텍스트 데이터셋

- 1.5.3 이산적인 입력 데이터 전처리

- 1.5.4 텍스트 데이터 전처리

- 1.5.5 결측 데이터 다루기

- 1.6 논의

- 1.6.1 ML과 다른 분야 간의 관계

- 1.6.2 이 책의 구조

- 1.6.3 주의할 점

- 1부 기초

- 02장. 확률: 일변량 모델

- 2.1 개요

- 2.1.1 확률이란 무엇인가?

- 2.1.2 불확실성의 형태

- 2.1.3 논리의 확장으로서의 확률

- 2.2 확률 변수

- 2.2.1 이산 확률 변수

- 2.2.2 연속 확률 변수

- 2.2.3 관련된 확률 변수의 집합

- 2.2.4 독립 및 조건부 독립

- 2.2.5 분포의 적률

- 2.2.6 요약 통계량의 한계*

- 2.3 베이즈 규칙

- 2.3.1 COVID-19 테스트

- 2.3.2 예시: 몬티 홀 문제

- 2.3.3 역 문제*

- 2.4 베르누이와 이항 분포

- 2.4.1 정의

- 2.4.2 시그모이드(로지스틱) 함수

- 2.4.3 이항 로지스틱 회귀

- 2.5 범주형 및 다항 분포

- 2.5.1 정의

- 2.5.2 소프트맥스 함수

- 2.5.3 다중 클래스 로지스틱 회귀

- 2.5.4 log-sum-exp 트릭

- 2.6 일변량 가우스(정규) 분포

- 2.6.1 누적 분포 함수

- 2.6.2 확률 밀도 함수

- 2.6.3 회귀

- 2.6.4 가우스 분포가 이처럼 널리 쓰이는 이유는 무엇인가?

- 2.6.5 극한의 경우로서의 디랙 델타 함수

- 2.7 일반적인 일변량 분포*

- 2.7.1 스튜던트 t 분포

- 2.7.2 코시 분포

- 2.7.3 라플라스 분포

- 2.7.4 베타 분포

- 2.7.5 감마 분포

- 2.7.6 경험적 분포

- 2.8 확률 변수의 변환*

- 2.8.1 이산형의 경우

- 2.8.2 연속형의 경우

- 2.8.3 가역 변환(전단사)

- 2.8.4 선형 변환의 적률

- 2.8.5 합성곱 정리

- 2.8.6 중심 극한 정리

- 2.8.7 몬테카를로 근사

- 2.9 연습문제

- 03장. 확률: 다변량 모델

- 3.1 여러 확률 변수의 결합 분포

- 3.1.1 공분산

- 3.1.2 상관

- 3.1.3 무상관은 독립을 뜻하지 않는다

- 3.1.4 상관성은 인과성을 뜻하지 않는다

- 3.1.5 심슨의 역설

- 3.2 다변량 가우스(정규) 분포

- 3.2.1 정의

- 3.2.2 마할라노비스 거리

- 3.2.3 MVN의 주변 및 조건부 분포*

- 3.2.4 예시: 2차원 가우스 조건부화

- 3.2.5 예시: 결측값 대체*

- 3.3 선형 가우스 체계*

- 3.3.1 가우스를 위한 베이즈 규칙

- 3.3.2 유도*

- 3.3.3 알 수 없는 스칼라 추론하기

- 3.3.4 예시: 알 수 없는 벡터 추론

- 3.3.5 예시: 센서 퓨전

- 3.4 지수족*

- 3.4.1 정의

- 3.4.2 예시

- 3.4.3 로그 분할 함수는 누율 생성 함수다

- 3.4.4 지수족의 최대 엔트로피 미분

- 3.5 혼합 모델

- 3.5.1 가우스 혼합 모델

- 3.5.2 베르누이 혼합 모델

- 3.6 확률적 그래프 모델*

- 3.6.1 표현

- 3.6.2 추론

- 3.6.3 학습

- 3.7 연습문제

- 04장. 통계학

- 4.1 소개

- 4.2 최대 가능도 추정(MLE)

- 4.2.1 정의

- 4.2.2 MLE의 정당화

- 4.2.3 예시: 베르누이 분포의 MLE

- 4.2.4 예시: 범주형 분포의 MLE

- 4.2.5 예시: 일변량 가우스의 MLE

- 4.2.6 예시: 다변량 가우스의 MLE

- 4.2.7 예시: 선형 회귀의 MLE

- 4.3 경험적 위험 최소화(ERM)

- 4.3.1 예시: 오분류율 최소화

- 4.3.2 대리 손실

- 4.4 그 밖의 추정 방법*

- 4.4.1 적률법

- 4.4.2 온라인 (재귀) 추정

- 4.5 정칙화

- 4.5.1 예시: 베르누이 분포의 MAP 추정

- 4.5.2 예시: 다변량 가우스를 위한 MAP 추정*

- 4.5.3 예시: 가중치 소멸

- 4.5.4 검증 집합을 사용해 정칙자 고르기

- 4.5.5 교차 검증

- 4.5.6 조기 중단

- 4.5.7 더 많은 데이터 사용하기

- 4.6 베이즈 통계학*

- 4.6.1 켤레 사전 분포

- 4.6.2 베타 이항 모델

- 4.6.3 디리클레-다항 모델

- 4.6.4 가우스-가우스 모델

- 4.6.5 켤레 사전 분포를 넘어서

- 4.6.6 신용 구간

- 4.6.7 베이즈 머신러닝

- 4.6.8 연산적 이슈

- 4.7 빈도주의 통계학*

- 4.7.1 표본 분포

- 4.7.2 MLE의 표본 분포의 가우스 근사

- 4.7.3 임의 추정량의 표본 분포의 부트스트랩 근사

- 4.7.4 신뢰 구간

- 4.7.5 주의: 신뢰 구간은 신용할 만하지 않다

- 4.7.6 편향-분산 트레이드오프

- 4.8 연습문제

- 05장. 결정 이론

- 5.1 베이즈 결정 이론

- 5.1.1 기초

- 5.1.2 분류 문제

- 5.1.3 ROC 곡선

- 5.1.4 정밀도-재현율 곡선

- 5.1.5 회귀 문제

- 5.1.6 확률적 예측 문제

- 5.2 ‘올바른’ 모델 선택

- 5.2.1 베이즈 가설 검정

- 5.2.2 베이즈 모델 선택

- 5.2.3 오컴의 면도날

- 5.2.4 교차 검증과 주변 가능도 사이의 관계

- 5.2.5 정보 기준

- 5.2.6 효과 크기에 대한 사후 추론 및 베이즈 유의도 검정

- 5.3 빈도주의 결정 이론

- 5.3.1 추정량의 위험 계산하기

- 5.3.2 일치추정량

- 5.3.3 허용 가능 추정량

- 5.4 경험적 위험 최소화

- 5.4.1 경험적 위험

- 5.4.2 구조적 위험

- 5.4.3 교차 검증

- 5.4.4 통계적 학습론*

- 5.5 빈도주의 가설 검정*

- 5.5.1 가능도비 검정

- 5.5.2 귀무가설 유의도 검정(NHST)

- 5.5.3 p 값

- 5.5.4 p 값은 유해하다고 간주됨

- 5.5.5 왜 모두가 베이즈적이지 않은가?

- 5.6 연습문제

- 06장. 정보 이론

- 6.1 엔트로피

- 6.1.1 이산 확률 변수의 엔트로피

- 6.1.2 교차 엔트로피

- 6.1.3 결합 엔트로피

- 6.1.4 조건부 엔트로피

- 6.1.5 퍼플렉서티

- 6.1.6 연속 확률 변수를 위한 미분 엔트로피*

- 6.2 상대 엔트로피(KL 발산)*

- 6.2.1 정의

- 6.2.2 해석

- 6.2.3 예시: 두 가우스 사이의 KL 발산

- 6.2.4 KL의 비음성

- 6.2.5 KL 발산과 MLE

- 6.2.6 전진 KL 대 후진 KL

- 6.3 상호 정보*

- 6.3.1 정의

- 6.3.2 해석

- 6.3.3 예시

- 6.3.4 조건부 상호 정보

- 6.3.5 ‘일반화 상관계수’로서의 MI

- 6.3.6 정규화 상호 정보

- 6.3.7 최대 정보 계수

- 6.3.8 데이터 처리 부등식

- 6.3.9 충분 통계량

- 6.3.10 파노의 부등식*

- 6.4 연습문제

- 07장. 선형대수

- 7.1 소개

- 7.1.1 표기법

- 7.1.2 벡터 공간

- 7.1.3 벡터와 행렬의 노름

- 7.1.4 행렬의 속성

- 7.1.5 특별한 형태의 행렬

- 7.2 행렬 곱셈

- 7.2.1 벡터-벡터 곱

- 7.2.2 행렬-벡터 곱

- 7.2.3 행렬-행렬 곱

- 7.2.4 응용: 데이터 행렬 조작

- 7.2.5 크로네커 곱*

- 7.2.6 아인슈타인 합*

- 7.3 역행렬

- 7.3.1 정방 행렬의 역

- 7.3.2 슈어 보수*

- 7.3.3 역행렬 보조정리*

- 7.3.4 행렬식 보조정리*

- 7.3.5 응용: MVN의 조건부 분포 유도하기*

- 7.4 고윳값 분해(EVD)

- 7.4.1 기본

- 7.4.2 대각화

- 7.4.3 대칭 행렬의 고윳값과 고유벡터

- 7.4.4 이차 형식의 기하학

- 7.4.5 데이터 표준화 및 백색화

- 7.4.6 거듭제곱법

- 7.4.7 수축

- 7.4.8 고유벡터는 이차 형식을 최적화한다

- 7.5 특잇값 분해(SVD)

- 7.5.1 기본

- 7.5.2 SVD와 EVD 사이의 관계

- 7.5.3 유사 역행렬

- 7.5.4 행렬의 SVD와 치역 및 영공간*

- 7.5.5 절단된 SVD

- 7.6 그 밖의 행렬 분해*

- 7.6.1 LU 인수분해

- 7.6.2 QR 분해

- 7.6.3 촐레스키 분해

- 7.7 선형 연립방정식 풀기*

- 7.7.1 정방 체계 풀기

- 7.7.2 과소제약 체계 풀기(최소 노름 추정)

- 7.7.3 과대제약 체계 풀기(최소 제곱 추정)

- 7.8 행렬 미적분

- 7.8.1 도함수

- 7.8.2 기울기

- 7.8.3 방향 도함수

- 7.8.4 전도함수*

- 7.8.5 야코비

- 7.8.6 헤세

- 7.8.7 주로 쓰이는 함수의 기울기

- 7.9 연습문제

- 08장. 최적화

- 8.1 개요

- 8.1.1 국소 대 전역 최적화

- 8.1.2 제약 대 비제약 최적화

- 8.1.3 볼록 대 비볼록 최적화

- 8.1.4 평활 대 비평활 최적화

- 8.2 일계법

- 8.2.1 하강 방향

- 8.2.2 단계 크기(학습률)

- 8.2.3 수렴률

- 8.2.4 운동량 방법

- 8.3 이계법

- 8.3.1 뉴턴법

- 8.3.2 BFGS 및 그 밖의 준뉴턴법

- 8.3.3 신뢰 영역법

- 8.4 확률적 경사하강

- 8.4.1 유한합 문제로의 응용

- 8.4.2 예시: 선형 회귀 적합을 위한 SGD

- 8.4.3 단계 크기(학습률) 정하기

- 8.4.4 반복 평균화

- 8.4.5 분산 축소*

- 8.4.6 선조건부 SGD

- 8.5 제약 최적화

- 8.5.1 라그랑주 승수

- 8.5.2 KKT 조건

- 8.5.3 선형 프로그래밍

- 8.5.4 이차 프로그래밍

- 8.5.5 혼합 정수 선형 프로그래밍*

- 8.6 프록시말 경사법*

- 8.6.1 사영된 경사하강

- 8.6.2 l1-노름 정칙자를 위한 프록시말 연산자

- 8.6.3 양자화를 위한 프록시말 연산자

- 8.6.4 증분 (온라인) 프록시말 방법

- 8.7 경계 최적화*

- 8.7.1 일반적인 알고리듬

- 8.7.2 EM 알고리듬

- 8.7.3 예시: GMM을 위한 EM

- 8.8 블랙박스 및 도함수 자유 최적화

- 8.9 연습문제

- 2부. 선형 모델

- 09장. 선형 판별분석

- 9.1 개요

- 9.2 가우스 판별분석

- 9.2.1 이차 결정 경계

- 9.2.2 선형 결정 경계

- 9.2.3 LDA와 로지스틱 회귀 사이의 연결점

- 9.2.4 모델 적합시키기

- 9.2.5 최근접 중심점 분류기

- 9.2.6 피셔의 선형 판별분석*

- 9.3 나이브 베이즈 분류기

- 9.3.1 예시 모델

- 9.3.2 모델 적합시키기

- 9.3.3 베이즈적인 나이브 베이즈

- 9.3.4 나이브 베이즈와 로지스틱 회귀 사이의 연결점

- 9.4 생성적 분류기와 판별 분류기

- 9.4.1 판별 분류기의 장점

- 9.4.2 생성적 분류기의 장점

- 9.4.3 결측 특성 다루기

- 9.5 연습문제

- 10장. 로지스틱 회귀

- 10.1 개요

- 10.2 이항 로지스틱 회귀

- 10.2.1 선형 분류기

- 10.2.2 비선형 분류기

- 10.2.3 최대 가능도 추정

- 10.2.4 확률적 경사하강

- 10.2.5 퍼셉트론 알고리듬

- 10.2.6 반복적 재가중 최소 제곱

- 10.2.7 MAP 추정

- 10.2.8 표준화

- 10.3 다변량 로지스틱 회귀

- 10.3.1 선형 및 비선형 분류기

- 10.3.2 최대 가능도 추정

- 10.3.3 기울기 기반 최적화

- 10.3.4 경계 최적화

- 10.3.5 MAP 추정

- 10.3.6 최대 엔트로피 분류기

- 10.3.7 계층적 분류

- 10.3.8 많은 수의 클래스 다루기

- 10.4 로버스트 로지스틱 회귀*

- 10.4.1 가능도를 위한 혼합 모델

- 10.4.2 이중 완화 손실

- 10.5 베이즈 로지스틱 회귀*

- 10.5.1 라플라스 근사

- 10.5.2 사후 예측 분포 근사하기

- 10.6 연습문제

- 11장. 선형 회귀

- 11.1 개요

- 11.2 최소 제곱 선형 회귀

- 11.2.1 용어

- 11.2.2 최소 제곱 추정

- 11.2.3 MLE를 계산하는 다른 접근법

- 11.2.4 적합도 측정하기

- 11.3 릿지 회귀

- 11.3.1 MAP 추정값 계산하기

- 11.3.2 릿지 회귀와 PCA 사이의 연결점

- 11.3.3 정칙자의 강도 선택하기

- 11.4 라쏘 회귀

- 11.4.1 라플라스 사전 분포를 갖는 MAP 추정(l1 정칙화)

- 11.4.2 왜 l1 정칙화는 희박한 해를 내놓는가?

- 11.4.3 딱딱한 임계화 대 부드러운 임계화

- 11.4.4 정칙화 경로

- 11.4.5 최소 제곱, 라쏘, 릿지, 부분집합 선택 비교

- 11.4.6 변수 선택 일관성

- 11.4.7 그룹 라쏘

- 11.4.8 엘라스틱넷(릿지와 라쏘 조합)

- 11.4.9 최적화 알고리듬

- 11.5 회귀 스플라인*

- 11.5.1 B 스플라인 기저 함수

- 11.5.2 스플라인 기저를 사용해 선형 모델 적합시키기

- 11.5.3 평활 스플라인

- 11.5.4 일반화 가법 모델

- 11.6 로버스트 선형 회귀*

- 11.6.1 라플라스 가능도

- 11.6.2 스튜던트-t 가능도

- 11.6.3 후버 손실

- 11.6.4 RANSAC

- 11.7 베이즈 선형 회귀*

- 11.7.1 사전 분포

- 11.7.2 사후 분포

- 11.7.3 예시

- 11.7.4 사후 예측 계산하기

- 11.7.5 중심화의 이점

- 11.7.6 다중공선성 처리하기

- 11.7.7 자동 적절성 결정(ARD)*

- 11.8 연습문제

- 12장. 일반화 선형 모델*

- 12.1 개요

- 12.2 예시

- 12.2.1 선형 회귀

- 12.2.2 이항 회귀

- 12.2.3 푸아송 회귀

- 12.3 비정준 링크 함수로 된 GLM

- 12.4 최대 가능도 추정

- 12.5 가공된 예시: 보험 청구 예측하기

- 3부. 심층 신경망

- 13장. 표 데이터를 위한 신경망

- 13.1 개요

- 13.2 다층 퍼셉트론(MLP)

- 13.2.1 XOR 문제

- 13.2.2 미분 가능한 MLP

- 13.2.3 활성 함수

- 13.2.4 예시 모델

- 13.2.5 깊이의 중요성

- 13.2.6 ‘딥러닝 혁명’

- 13.2.7 생물학과의 연결점

- 13.3 역전파

- 13.3.1 포워드 대 리버스 방식 미분

- 13.3.2 다층 퍼셉트론을 위한 리버스 방식 미분

- 13.3.3 보통의 층을 위한 벡터 야코비 곱

- 13.3.4 계산 그래프

- 13.4 신경망 훈련

- 13.4.1 학습률 튜닝

- 13.4.2 기울기 소실 및 폭증

- 13.4.3 비포화 활성 함수

- 13.4.4 잔차 연결

- 13.4.5 모수 초기화

- 13.4.6 병렬 훈련

- 13.5 정칙화

- 13.5.1 조기 중단

- 13.5.2 가중치 소멸

- 13.5.3 희박 DNN

- 13.5.4 드롭아웃

- 13.5.5 베이즈 신경망

- 13.5.6 (확률적) 경사하강의 정칙화 효과*

- 13.6 다른 종류의 피드포워드 네트워크*

- 13.6.1 방사 기저 함수 네트워크

- 13.6.2 전문가 혼합

- 13.7 연습문제

- 14장. 이미지를 위한 신경망

- 14.1 개요

- 14.2 일반적인 층

- 14.2.1 합성곱 층

- 14.2.2 풀링 층

- 14.2.3 한데 모으기

- 14.2.4 정규화 층

- 14.3 이미지 분류를 위한 일반적인 아키텍처

- 14.3.1 LeNet

- 14.3.2 AlexNet

- 14.3.3 GoogLeNet(인셉션)

- 14.3.4 ResNet

- 14.3.5 DenseNet

- 14.3.6 신경 아키텍처 검색

- 14.4 다른 형태의 합성곱*

- 14.4.1 팽창 합성곱

- 14.4.2 전치 합성곱

- 14.4.3 깊이별 분리 가능 합성곱

- 14.5 CNN으로 다른 판별적인 비전 과제 풀기*

- 14.5.1 이미지 태깅

- 14.5.2 물체 탐지

- 14.5.3 인스턴스 세분화

- 14.5.4 의미론적 세분화

- 14.5.5 인간 자세 추정

- 14.6 CNN을 뒤집어 이미지 생성하기*

- 14.6.1 훈련된 분류기를 생성 모델로 변환하기

- 14.6.2 이미지 사전 분포

- 14.6.3 CNN으로 학습한 특성 시각화하기

- 14.6.4 딥드림

- 14.6.5 뉴럴 스타일 트랜스퍼

- 15장. 시퀀스를 위한 신경망

- 15.1 개요

- 15.2 순환 신경망(RNN)

- 15.2.1 vec2seq(시퀀스 생성)

- 15.2.2 seq2vec(시퀀스 분류)

- 15.2.3 seq2seq(시퀀스 번역)

- 15.2.4 선생의 강요

- 15.2.5 시간을 통한 역전파

- 15.2.6 기울기 소실 및 폭주

- 15.2.7 게이트 및 장기 메모리

- 15.2.8 빔 검색

- 15.3 1차원 CNN

- 15.3.1 시퀀스 분류를 위한 1차원 합성곱

- 15.3.2 시퀀스 생성을 위한 인과적 1d CNN

- 15.4 어텐션

- 15.4.1 소프트 딕셔너리 룩업으로서의 어텐션

- 15.4.2 비모수 어텐션으로서의 커널 회귀

- 15.4.3 모수적 어텐션

- 15.4.4 어텐션이 있는 seq2seq

- 15.4.5 어텐션이 있는 seq2vec(텍스트 분류)

- 15.4.6 어텐션이 있는 Seq+Seq2Vec(텍스트 쌍 분류)

- 15.4.7 소프트 어텐션과 하드 어텐션

- 15.5 트랜스포머

- 15.5.1 셀프 어텐션

- 15.5.2 멀티헤드 어텐션

- 15.5.3 위치적 인코딩

- 15.5.4 모두 한데 모으기

- 15.5.5 트랜스포머, CNN, RNN 비교하기

- 15.5.6 이미지를 위한 트랜스포머*

- 15.5.7 그 밖의 트랜스포머 변형*

- 15.6 효율적 트랜스포머*

- 15.6.1 고정된 학습 불가능한 국소화된 어텐션 패턴

- 15.6.2 학습 가능한 희박 어텐션 패턴

- 15.6.3 메모리 및 순환 방법

- 15.6.4 저계수 및 커널 방법

- 15.7 언어 모델 및 비지도 표현 학습

- 15.7.1 ELMo

- 15.7.2 BERT

- 15.7.3 GPT

- 15.7.4 T5

- 15.7.5 논의

- 4부. 비모수적 모델

- 16장. 전형 기반 모델

- 16.1 K 최근접 이웃(KNN) 분류

- 16.1.1 예시

- 16.1.2 차원성의 저주

- 16.1.3 속도 및 메모리 요구를 줄이기

- 16.1.4 열린 집합 인식

- 16.2 거리 계량 학습

- 16.2.1 선형 및 볼록법

- 16.2.2 심층 계량 학습

- 16.2.3 분류 손실

- 16.2.4 랭킹 손실

- 16.2.5 랭킹 손실 최적화 빠르게 하기

- 16.2.6 DML을 위한 그 밖의 훈련 요령

- 16.3 커널 밀도 추정(KDE)

- 16.3.1 밀도 커널

- 16.3.2 파젠 윈도 밀도 추정량

- 16.3.3 대역폭 모수를 선택하는 방법

- 16.3.4 KDE에서 KNN 분류로

- 16.3.5 커널 회귀

- 17장. 커널법*

- 17.1 머서 커널

- 17.1.1 머서의 정리

- 17.1.2 몇 가지 인기 있는 머서 커널

- 17.2 가우스 과정

- 17.2.1 잡음 자유 관측치

- 17.2.2 잡음이 있는 관측치

- 17.2.3 커널 회귀와의 비교

- 17.2.4 가중치 공간 대 함수 공간

- 17.2.5 수치적인 이슈

- 17.2.6 커널 추정하기

- 17.2.7 분류를 위한 GP

- 17.2.8 딥러닝과의 연결점

- 17.2.9 GP를 커다란 데이터셋으로 스케일링하기

- 17.3 서포트 벡터 머신(SVM)

- 17.3.1 넓은 마진 분류기

- 17.3.2 쌍대 문제

- 17.3.3 소프트 마진 분류기

- 17.3.4 커널 트릭

- 17.3.5 SVM 출력을 확률로 바꾸기

- 17.3.6 로지스틱 회귀와의 연결점

- 17.3.7 SVM으로 하는 다중 클래스 분류

- 17.3.8 정칙자 C 를 선택하는 방법

- 17.3.9 커널 릿지 회귀

- 17.3.10 회귀를 위한 SVM

- 17.4 희박 벡터 머신

- 17.4.1 적절성 벡터 머신(RVM)

- 17.4.2 희박 커널법과 밀집 커널법 비교

- 17.5 연습문제

- 18장. 트리, 포레스트, 배깅, 부스팅

- 18.1 분류와 회귀 트리(CART)

- 18.1.1 모델 정의

- 18.1.2 모델 적합

- 18.1.3 정칙화

- 18.1.4 결측 입력 특성 다루기

- 18.1.5 장점과 단점

- 18.2 앙상블 학습

- 18.2.1 스태킹

- 18.2.2 앙상블은 베이즈 모델 평균화가 아니다

- 18.3 배깅

- 18.4 랜덤 포레스트

- 18.5 부스팅

- 18.5.1 전진 스테이지별 가법 모델링

- 18.5.2 이차 손실과 최소 제곱 부스팅

- 18.5.3 지수 손실과 AdaBoost

- 18.5.4 LogitBoost

- 18.5.5 경사 부스팅

- 18.6 트리 앙상블 해석하기

- 18.6.1 특성 중요도

- 18.6.2 부분 의존성 도표

- 5부. 지도 학습 너머로

- 19장. 라벨링된 적은 예제로의 학습

- 19.1 데이터 덧붙이기

- 19.1.1 예시

- 19.1.2 이론적 정당화

- 19.2 전이 학습

- 19.2.1 미조정

- 19.2.2 어댑터

- 19.2.3 지도적 사전훈련

- 19.2.4 비지도 사전훈련(자기 지도 학습)

- 19.2.5 도메인 적응

- 19.3 준지도 학습

- 19.3.1 자기 훈련과 유사 라벨링

- 19.3.2 엔트로피 최소화

- 19.3.3 공동 훈련

- 19.3.4 그래프에서의 라벨 전파

- 19.3.5 일관성 정칙화

- 19.3.6 심층 생성 모델*

- 19.3.7 자기 지도 학습과 준지도 학습 조합하기

- 19.4 활동 학습

- 19.4.1 결정 이론적인 접근법

- 19.4.2 정보 이론적인 접근법

- 19.4.3 배치 활동 학습

- 19.5 메타 학습

- 19.5.1 모델 불가지한 메타 학습(MAML)

- 19.6 퓨샷 학습

- 19.6.1 매칭 네트워크

- 19.7 약하게 지도적인 학습

- 19.8 연습문제

- 20장. 차원성 축소

- 20.1 주성분 분석(PCA)

- 20.1.1 예시

- 20.1.2 알고리듬의 유도

- 20.1.3 연산적인 이슈

- 20.1.4 잠재 차원의 개수 선택하기

- 20.2 인자 분석*

- 20.2.1 생성 모델

- 20.2.2 확률적 PCA

- 20.2.3 FA/PPCA를 위한 EM 알고리듬

- 20.2.4 모수의 비식별 가능성

- 20.2.5 비선형 인자 분석

- 20.2.6 인자 분석자의 혼합

- 20.2.7 지수족 인자 분석

- 20.2.8 쌍 데이터를 위한 인자 분석 모델

- 20.3 오토인코더

- 20.3.1 병목 오토인코더

- 20.3.2 디노이징 오토인코더

- 20.3.3 수축적 오토인코더

- 20.3.4 희박 오토인코더

- 20.3.5 변분 오토인코더

- 20.4 다양체 학습*

- 20.4.1 다양체란 무엇인가?

- 20.4.2 다양체 가설

- 20.4.3 다양체 학습 접근법

- 20.4.4 다중 차원적 스케일링(MDS)

- 20.4.5 Isomap

- 20.4.6 커널 PCA

- 20.4.7 최대 분산 펼침(MVU)

- 20.4.8 국소 선형 임베딩(LLE)

- 20.4.9 라플라스 고유맵

- 20.4.10 t-SNE

- 20.5 단어 임베딩

- 20.5.1 잠재 의미 분석 / 인덱싱

- 20.5.2 Word2vec

- 20.5.3 GloVE

- 20.5.4 단어 유사성

- 20.5.5 단어 임베딩의 RAND-WALK 모델

- 20.5.6 컨텍스트적 언어 임베딩

- 20.6 연습문제

- 21장. 군집화

- 21.1 개요

- 21.1.1 군집화 방법의 출력 평가하기

- 21.2 계층적 응집 군집화

- 21.2.1 알고리듬

- 21.2.2 예시

- 21.2.3 확장

- 21.3 K 평균 군집화

- 21.3.1 알고리듬

- 21.3.2 예시

- 21.3.3 벡터 양자화

- 21.3.4 K 평균++ 알고리듬

- 21.3.5 K 중위점 알고리듬

- 21.3.6 가속 트릭

- 21.3.7 군집의 수 K 선택하기

- 21.4 혼합 모델을 사용한 군집화

- 21.4.1 가우스 혼합

- 21.4.2 베르누이 혼합

- 21.5 스펙트럼 군집화*

- 21.5.1 정규화 절단

- 21.5.2 군집화를 인코딩하는 그래프 라플라스의 고유벡터

- 21.5.3 예시

- 21.5.4 다른 방법과의 연결점

- 21.6 이중군집화*

- 21.6.1 기본적인 이중군집화

- 21.6.2 중첩 분할 모델(crosscat)

- 22장. 추천 시스템

- 22.1 명시적 피드백

- 22.1.1 데이터셋

- 22.1.2 협업 필터링

- 22.1.3 행렬 분해

- 22.1.4 오토인코더

- 22.2 암묵적 피드백

- 22.2.1 베이즈 개인화 순위

- 22.2.2 분해 머신

- 22.2.3 신경 행렬 분해

- 22.3 부가 정보 활용하기

- 22.4 탐색-활용 상반관계

- 23장. 그래프 임베딩*

- 23.1 개요

- 23.2 인코더/디코더 문제로서의 그래프 임베딩

- 23.3 얕은 그래프 임베딩

- 23.3.1 비지도 임베딩

- 23.3.2 거리 기반: 유클리드법

- 23.3.3 거리 기반: 비유클리드법

- 23.3.4 외적 기반: 행렬 분해법

- 23.3.5 외적 기반: 스킵그램법

- 23.3.6 지도적 임베딩

- 23.4 그래프 신경망

- 23.4.1 메시지 전달 GNN

- 23.4.2 스펙트럼 그래프 합성곱

- 23.4.3 공간적 그래프 합성곱

- 23.4.4 비유클리드 그래프 합성곱

- 23.5 심층 그래프 임베딩

- 23.5.1 비지도적 임베딩

- 23.5.2 준지도 임베딩

- 23.6 응용

- 23.6.1 비지도적 응용

- 23.6.2 지도적인 응용

- 부록 A. 표기법

도서 오류 신고

정오표

정오표

[82p : 위에서 2행]

Pr(AvB) - 2/4 x 1/4

->

Pr(AvB) - 2/4 + 1/4